машинное обучение — модель CNTK Evaluate имеет два входа Переполнение стека

У меня есть проект на основе CNTK 2.3. Я использовал код из интеграционных тестов для обучения классификатора MNIST следующим образом:

auto device = DeviceDescriptor::GPUDevice(0);

const size_t inputDim = sizeBlob * sizeBlob;

const size_t numOutputClasses = numberOfClasses;

const size_t hiddenLayerDim = 200;

auto input = InputVariable({ inputDim }, CNTK::DataType::Float, L"features");

auto scaledInput = ElementTimes(Constant::Scalar(0.00390625f, device), input);

auto classifierOutput = FullyConnectedDNNLayer(scaledInput, hiddenLayerDim, device, std::bind(Sigmoid, _1, L""));

auto outputTimesParam = Parameter(NDArrayView::RandomUniform<float>({ numOutputClasses, hiddenLayerDim }, -0.05, 0.05, 1, device));

auto outputBiasParam = Parameter(NDArrayView::RandomUniform<float>({ numOutputClasses }, -0.05, 0.05, 1, device));

classifierOutput = Plus(outputBiasParam, Times(outputTimesParam, classifierOutput), L"classifierOutput");

auto labels = InputVariable({ numOutputClasses }, CNTK::DataType::Float, L"labels");

auto trainingLoss = CNTK::CrossEntropyWithSoftmax(classifierOutput, labels, L"lossFunction");;

auto prediction = CNTK::ClassificationError(classifierOutput, labels, L"classificationError");

// Test save and reload of model

Variable classifierOutputVar = classifierOutput;

Variable trainingLossVar = trainingLoss;

Variable predictionVar = prediction;

auto combinedNet = Combine({ trainingLoss, prediction, classifierOutput }, L"MNISTClassifier");

//SaveAndReloadModel<float>(combinedNet, { &input, &labels, &trainingLossVar, &predictionVar, &classifierOutputVar }, device);

classifierOutput = classifierOutputVar;

trainingLoss = trainingLossVar;

prediction = predictionVar;const size_t minibatchSize = 64;

const size_t numSamplesPerSweep = 60000;

const size_t numSweepsToTrainWith = 2;

const size_t numMinibatchesToTrain = (numSamplesPerSweep * numSweepsToTrainWith) / minibatchSize;

auto featureStreamName = L"features";

auto labelsStreamName = L"labels";

auto minibatchSource = TextFormatMinibatchSource(trainingSet, { { featureStreamName, inputDim },{ labelsStreamName, numOutputClasses } });

auto featureStreamInfo = minibatchSource->StreamInfo(featureStreamName);

auto labelStreamInfo = minibatchSource->StreamInfo(labelsStreamName);

LearningRateSchedule learningRatePerSample = TrainingParameterPerSampleSchedule<double>(0.003125);

auto trainer = CreateTrainer(classifierOutput, trainingLoss, prediction, { SGDLearner(classifierOutput->Parameters(), learningRatePerSample) });

size_t outputFrequencyInMinibatches = 20;

for (size_t i = 0; i < numMinibatchesToTrain; ++i)

{

auto minibatchData = minibatchSource->GetNextMinibatch(minibatchSize, device);

trainer->TrainMinibatch({ { input, minibatchData[featureStreamInfo] },{ labels, minibatchData[labelStreamInfo] } }, device);

PrintTrainingProgress(trainer, i, outputFrequencyInMinibatches);

size_t trainingCheckpointFrequency = 100;

if ((i % trainingCheckpointFrequency) == (trainingCheckpointFrequency - 1))

{

const wchar_t* ckpName = L"feedForward.net";

//trainer->SaveCheckpoint(ckpName);

//trainer->RestoreFromCheckpoint(ckpName);

}

}

combinedNet->Save(g_dnnFile);

Эта часть работает нормально, и я тренирую модель, затем сохраняю в файл модели. Но когда я пытаюсь оценить простое изображение для проверки модели, кажется, что в модели что-то не так.

// Load the model.

// The model is trained by <CNTK>/Examples/Image/Classification/ResNet/Python/TrainResNet_CIFAR10.py

// Please see README.md in <CNTK>/Examples/Image/Classification/ResNet about how to train the model.

FunctionPtr modelFunc = Function::Load(modelFile, device);

// Get input variable. The model has only one single input.

std::vector<Variable> inputs = modelFunc->Arguments();

Variable inputVar = modelFunc->Arguments()[0];

// The model has only one output.

// If the model has more than one output, use modelFunc->Outputs to get the list of output variables.

std::vector<Variable> outputs = modelFunc->Outputs();

Variable outputVar = outputs[0];

// Prepare input data.

// For evaluating an image, you first need to perform some image preprocessing to make sure that the input image has the correct size and layout

// that match the model inputs.

// Please note that the model used by this example expects the CHW image layout.

// inputVar.Shape[0] is image width, inputVar.Shape[1] is image height, and inputVar.Shape[2] is channels.

// For simplicity and avoiding external dependencies, we skip the preprocessing step here, and just use some artificially created data as input.

Mat image = imread(".....");

uint8_t* imagePtr = (uint8_t*)(image).data;

auto width = image.cols;

auto heigth = image.rows;std::vector<float> inputData(inputVar.Shape().TotalSize());

for (size_t i = 0; i < inputData.size(); ++i)

{

auto curChVal = imagePtr[(i)];

inputData[i] = curChVal;

}

// Create input value and input data map

ValuePtr inputVal = Value::CreateBatch(inputVar.Shape(), inputData, device);

std::unordered_map<Variable, ValuePtr> inputDataMap = { { inputVar, inputVal } };

// Create output data map. Using null as Value to indicate using system allocated memory.

// Alternatively, create a Value object and add it to the data map.

std::unordered_map<Variable, ValuePtr> outputDataMap = { { outputVar, nullptr } };

// Start evaluation on the device

modelFunc->Evaluate(inputDataMap, outputDataMap, device);

// Get evaluate result as dense output

ValuePtr outputVal = outputDataMap[outputVar];

std::vector<std::vector<float>> outputData;

outputVal->CopyVariableValueTo(outputVar, outputData);

PrintOutput<float>(outputVar.Shape().TotalSize(), outputData);

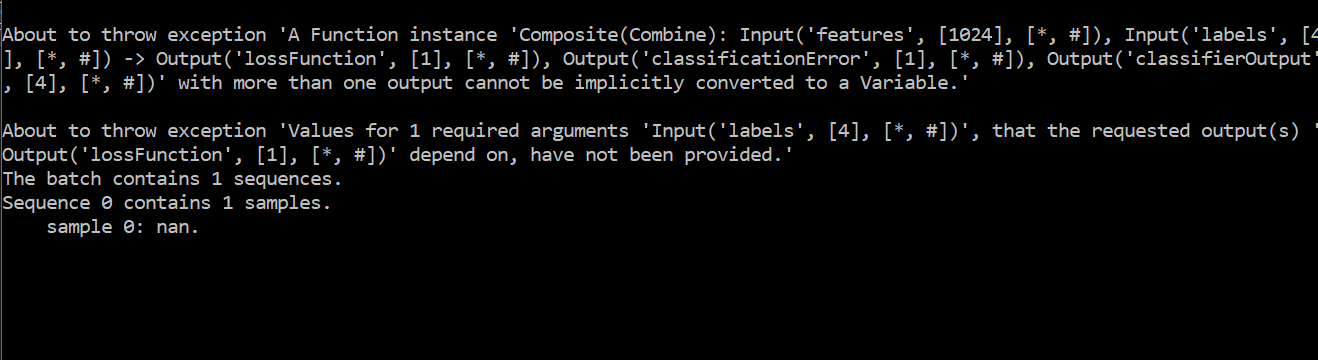

Я запускаю тот же код на C #, и он отлично работает. В качестве разницы я обнаружил, что modelFunc-> Arguments () должен иметь один аргумент, но он имеет два — он находит объекты и метки как два входа, но мне нужно иметь только функцию как вход, и он выдает следующую ошибку:

Решение

Найти входные и выходные переменные по имени, а не по modelFunc->Arguments()[0],

Variable inputVar;

GetInputVariableByName(modelFunc, L"features", inputVar);

Variable outputVar;

GetOutputVaraiableByName(modelFunc, L"classifierOutput", outputVar);

GetInputVariableByName а также GetOutputVaraiableByName() родом из

https://github.com/Microsoft/CNTK/blob/v2.3.1/Tests/EndToEndTests/EvalClientTests/CNTKLibraryCPPEvalExamplesTest/EvalMultithreads.cpp#L316

Другие решения

Других решений пока нет …